Projet réalisé dans le cadre du Consortium industriel FactoryLab avec le CEA-List, Safran, NAVAL GROUP, Stellantis, SLB et LS GROUP.

Contexte

L’automatisation totale de tâches manuelles pénibles ou répétitives se heurte à la difficulté technique et au coût de mise en œuvre, limitant son application aux grandes séries et aux procédés répétables. Les autres contextes, tels que les petites séries, le sur-mesure, les opérations de réparation et de maintenance, etc., sont trop changeants, et requièrent des capacités d’adaptation et d’analyse du contexte auxquelles les solutions de programmation robotique conventionnelles, telle que la PHL (Programmation Hors Ligne), ne permettent pas de répondre. Ce problème amène aux questions suivantes :

- Comment conserver l’expertise et la capacité de décision de l’opérateur, tout en l’assistant sur les tâches manuelles exigeantes ?

- Comment faire du système robotique un outil pour l’opérateur, adaptable rapidement aux spécificités de la situation ?

Dans ce contexte, l’objectif du projet INTUIPROG est de fournir une solution de programmation intuitive et interactive, compatible avec différentes marques et modèles de robots, et basée sur l’usage combiné de fonctions d’assistance et d’automatisation. Cette solution permet de configurer et déclencher en ligne de petites tâches d’assistance robotique à destination des opérateurs ou des non-roboticiens. Elle prend la forme d’une suite logicielle associée à du matériel de motion capture.

Enjeux & innovation

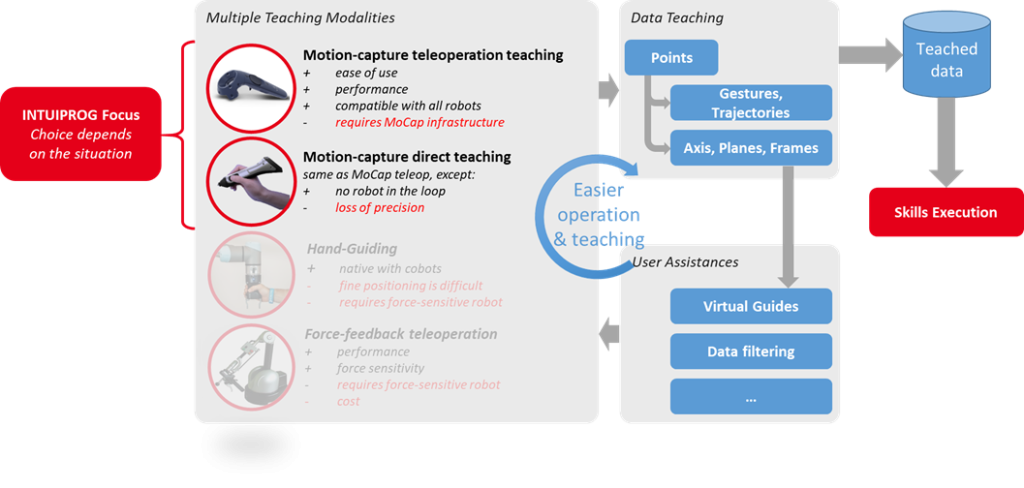

Le cœur d’INTUIPROG est une solution multimodale d’apprentissage par démonstration permettant l’exécution automatique de compétences robotiques, et intégrant :

- Module d’apprentissage flexible multimodal : motion-capture offline ou téléopéré, téléopération à retour d’effort, hand-guiding. Des fonctions d’assistance (guides virtuels, post-traitement des données apprises) permettent de faciliter la démonstration.

- Framework de compétences, c’est-à-dire de fonctions robotiques dédiées au métier de l’opérateur et permettant d’automatiser de petites tâches (ex. découpe de tuyaux, perçage, vissage, ponçage de surfaces, etc…).

- Interface graphique dédiée

Cette solution se distingue notamment par les points-clé suivants :

- Solution intuitive pour l’opérateur

- Compatible avec tous types de robots (robots industriels, robots collaboratifs, cobots)

- Permet l’apprentissage par démonstration sans contact (depuis l’extérieur d’une cellule robotique par exemple)

- Adaptation simple et rapide aux changements de procédés

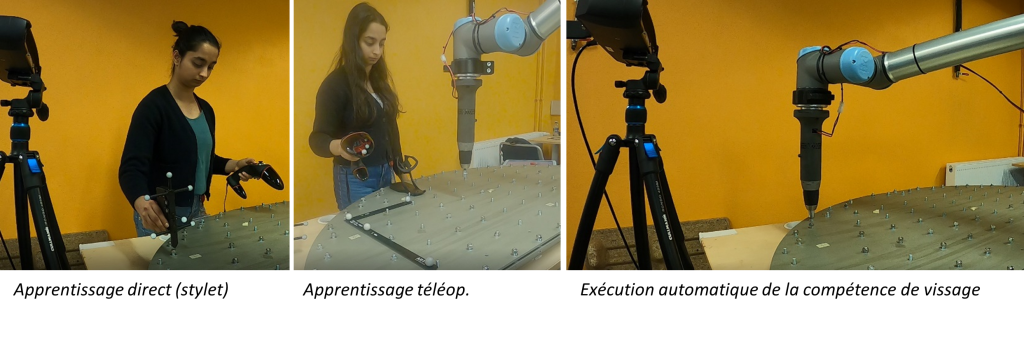

Le flux de travail résultant est illustré dans la figure suivante. En fonction du contexte, l’opérateur choisit la modalité d’apprentissage (téléopération ou apprentissage direct) la plus appropriée pour son besoin. Grâce au motion-capture Il apprend simplement au robot les points d’application de la compétence qu’il souhaite utiliser. Afin de faciliter l’apprentissage, il est possible d’apprendre des repères ou plans de travail, qui serviront à définir des guides virtuels d’assistance. Ces guides, en limitant les degrés de liberté du robot, rendent la téléopération encore plus aisée, et permettent à l’opérateur de se focaliser pleinement sur sa tâche.

Résultats

- Apprentissage multimodal via motion-capture

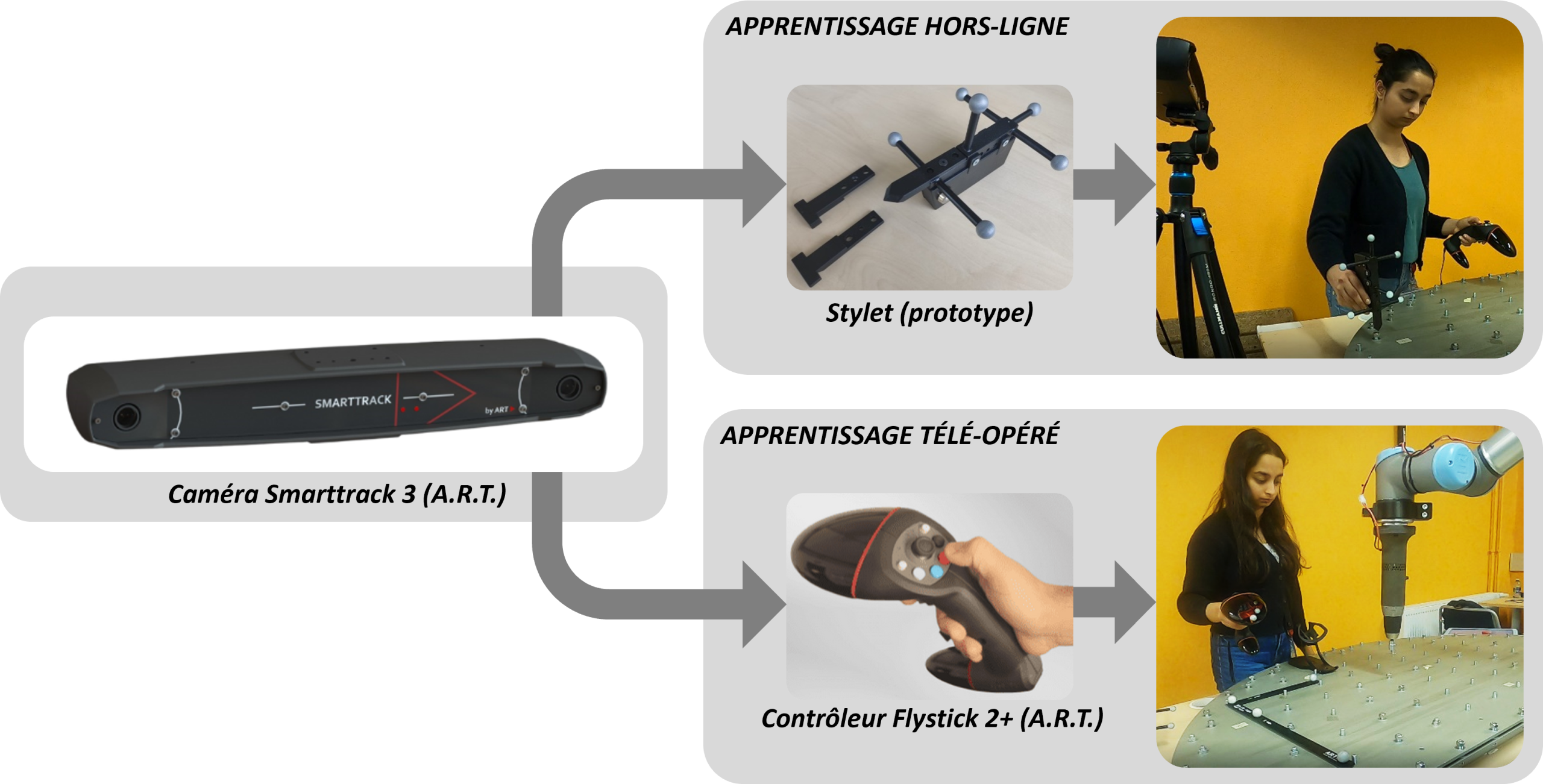

Après de premières expérimentations avec d’autre matériel (HTC Vive dans le projet européen MERGING), nous avons retenu le matériel de la marque A.R.T., qui se distingue par sa facilité de déploiement et sa précision de tracking. Le matériel utilisé est composé d’une caméra stéréo pré-calibrée, d’une télécommande Flystick2+ utilisée pour l’apprentissage téléopéré, et d’un stylet prototype utilisé pour l’apprentissage direct. A.R.T. Fournit également un stylet passif standard (measurement tool), qui peut être utilisé pour le même usage.

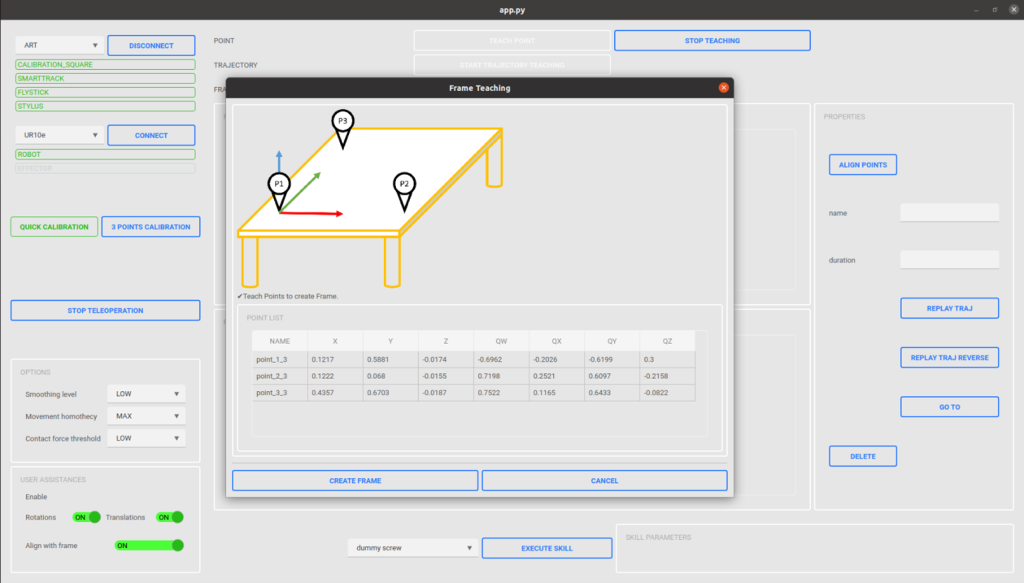

- Interface utilisateur et fonctions d’assistance

Un effort important a été consacré à l’interface utilisateur, car son ergonomie impacte directement l’ensemble du flux de travail. L’interface a été conçue pour rester minimale et facile d’usage, tout en fournissant l’ensemble des fonctionnalités nécessaires à l’usage du système : gestion et calibration du matériel (robot et MoCap), apprentissage de points, fonctions d’assistance, exécutions des compétences. La figure suivante illustre cette interface. Les fonctions (ici l’apprentissage de repère) sont documentées et illustrées pour faciliter leur prise en main.

- Démonstration sur cas d’usage

La solution a été mise en œuvre et évaluée sur un cas d’usage de vissage fourni par un des partenaires industriels du projet, pour lequel une maquette à échelle réduite a été réalisée. Les deux modalités d’apprentissage ont été implémentées et comparées.

En apprentissage direct avec stylet, l’opérateur apprend tous les points de vissage selon l’ordre souhaité. Il utilise une fonction d’assistance permettant de réorienter l’ensemble des points appris à la perpendiculaire du plan de travail. Il peut alors exécuter la compétence de vissage sur l’ensemble des points appris.

En apprentissage téléopéré, l’opérateur commence par apprendre le plan de travail, afin d’activer un guide virtuel bloquant le robot à la perpendiculaire du plan. Il peut alors apprendre l’ensemble des points, puis exécuter la compétence de vissage sur les points appris.

La précision absolue est meilleure en téléopération, mais les deux modalités fournissent globalement une précision suffisante pour la réalisation de la tâche. Sur un apprentissage de 70 écrous à visser, on obtient un taux de réussite de 98,5% en « direct teaching », et 100% en « téléoperation ».

| Hand guiding | Mocap direct | Mocap teleop | |

| Précision | ± 5mm | ± 3mm | ± 2mm |

| Rapidité | 6s / point | 2s / point | 6s / point |

| Difficulté physique | Difficile | Très facile | Facile |

| Charge mentale | Élevée | Minimale | Faible / moyenne |

De manière générale, les essais ont largement démontré l’efficacité du MoCap pour l’apprentissage (gain x2 à x3 en temps et en précision, comparé à un apprentissage cobotique en hand-guiding). L’apprentissage est également plus facile, que ça soit en termes de difficulté physique (en cobotique, il devient vite fatiguant d’apprendre des points éloignés) et en termes de charge mentale (obtenir une bonne précision en cobotique nécessite beaucoup de concentration, en raison des frottements du robot).

Perspectives

Les développements réalisés dans le cadre du projet INTUIPROG se poursuivent dans le cadre du projet européen JARVIS, qui se focalise sur deux volets. Le premier est l’évolution fonctionnelle du module de téléopération via Motion-Capture, via l’amélioration des performances de téléopération, le couplage avec contrôleur CORTEX, et l’ajout d’une interface de pilotage en réalité virtuelle / réalité augmentée. Le second est l’ajout d’un couplage temps-réel avec le jumeau numérique SCORE, qui permettra d’améliorer les possibilités de visualisation des données apprises en 3D, de bénéficier de fonctions de guides virtuels avancés, d’anticollision, et de planification de trajectoire. L’usage du jumeau numérique permettra également de valider les compétences en simulation avant de les exécuter sur système réel.

Auteur : Baptiste GRADOUSSOFF, chef de projet INTUIPROG, CEA-List.